Linux 소프트웨어 iSCSI 대상으로 저가 SAN을 설정하는 단계별 가이드

값 비싼 SAN 하드웨어를 구입하기에 충분한 반죽이 없을 때 소프트웨어 iSCSI 대상은 공유 스토리지를 설정하는 좋은 방법입니다. iSCSI 대상은 기존 하드웨어 (또는 심지어 VM!)에서 실행되는 소프트웨어 조각을 제외하고는 실제 하드웨어 iSCSI 배열과 동일하게 작동합니다. iSCSI 대상을 설정하면 필요한 공유 저장 장치를 쉽고 저렴한 비용으로 얻을 수 있습니다. GFS 나 OCFS 같은 클러스터 파일 시스템 인 Microsoft Windows Server Failover Clustering (WSFC)과 같은 클러스터링 제품을 사용하고 있다면 상관 없습니다. 또는 스토리지 풀링 및 라이브 마이그레이션을 활성화하여 가상화 플랫폼 (VMware, XenServer 또는 Hyper-V)을 최대한 활용하고자하는 경우에도 마찬가지입니다.

Lio-Target 정보

최근 Linux 커널은 Linux 용 표준 iSCSI 대상으로 LIO-Target을 채택했습니다. LIO-Target은 Linux 커널 3.1 이상에서 사용할 수 있습니다. LIO-Target은 Windows Server 장애 조치 클러스터링, VMware vSphere 및 기타 클러스터링 제품에 필요한 SCSI-3 영구 예약을 지원합니다. iSCSI 대상이 제공하는 LUN (디스크)은 전체 디스크, 파티션 또는 파일 시스템의 평범한 오래된 파일 일 수 있습니다. LIO-Target은 이러한 모든 옵션을 지원합니다. 아래에서는 Ubuntu 12.04 서버에서 LIO-Target을 구성하는 단계를 살펴 보겠습니다. 최근의 다른 배포판도 잘 작동하지만 단계가 약간 다를 수 있습니다.

구성 단계

먼저 Lio-target 패키지를 설치하십시오.

# apt-get install -no-install-recommends targetcli python-urwid Lio 타겟은 targetcli 명령 줄 유틸리티를 사용하여 제어됩니다. 첫 번째 단계는 LUN에 대한 백업 저장소를 만드는 것입니다. 이 예에서는 iSCSI 대상 서버의 파일 시스템에있는 일반 파일 인 파일 기반 LUN을 사용합니다. # targetcli /> cd 백 스토어 / / 백 스토어> ls o-backstores ……………………………………………. […] o- 파일 ………………………… ………………. [0 저장 개체] o- iblock ……………………………………… [0 저장 개체] o-pscsi ………………………………………… .. [0 저장 개체] o- rd_dr …………………………………….. .. [0 저장 개체] o- rd_mcp ……………………………………… lun0 / root / iscsi-lun0 2g (2GB 파일 백업 LUN 만들기)를 작성합니다. [0 Storage Object] / 백 스토어> cd fileio / backstores / fileio>

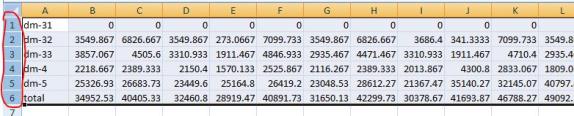

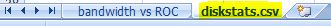

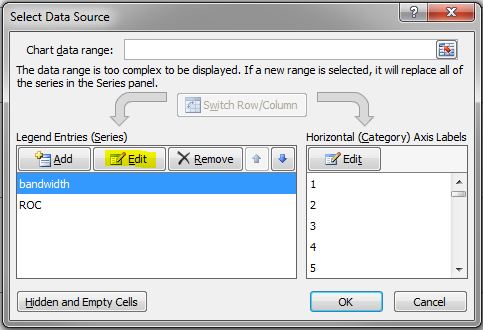

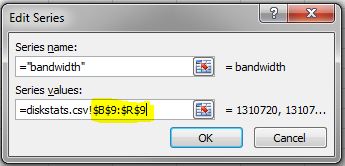

두번째 단계

이제 LUN이 생성됩니다. Linux 소프트웨어 iSCSI 대상으로 저비용 SAN을 설정하는 방법. 다음으로 클라이언트 시스템이 스토리지에 액세스 할 수 있도록 대상을 설정합니다. / backstores / fileio / lun0> cd / iscsi / iscsi> create (iqn 및 대상 포트 그룹 작성) 작성한 대상 iqn.2003-01.org.linux-iscsi.murray.x8664 : sn.31fc1a672ba1. 선택된 TPG 태그 1. TPG 1을 성공적으로 생성했습니다. 새 노드 입력 /iscsi/iqn.2003-01.org.linux-iscsi.murray.x8664:sn.31fc1a672ba1/tpgt1/iscsi/iqn.20…a672ba1/tpgt1> 속성 인증 설정 = 0 (챕터 인증 해제) / iscsi / iqn.20 … a672ba1 / tpgt1> cd luns /iscsi/iqn.20…a1/tpgt1/luns> create / backstores / fileio / lun0 (대상 LUN 만들기) 선택한 LUN 0. LUN 0을 (를) 성공적으로 생성했습니다. 새 노드 입력 /iscsi/iqn.2003-01.org.linux-iscsi.murray.x8664:sn.31fc1a672ba1/tpgt1/luns/lun0/iscsi/iqn.20…gt1/luns/lun0> cd ../ .. / 포털 iSCSI 트래픽은 많은 대역폭을 소비 할 수 있습니다. 아마도 iSCSI 트래픽은 공용 네트워크가 아닌 전용 (또는 SAN) 네트워크에 있어야합니다. /iscsi/iqn.20…tpgt1/portals> 10.10.102.164 만들기 (연결을 기다리는 포털 만들기) 기본 IP 포트 3260 사용 네트워크 포털 10.10.102.164:3260을 만들었습니다. 새 노드 입력 /iscsi/iqn.2003-01.org.linux-iscsi.murray.x8664:sn.31fc1a672ba1/tpgt1/portals/10.10.102.164:3260 /iscsi/iqn.20….102.164:3260> cd .. /iscsi/iqn.20…tpgt1/portals> 10.11.102.164 만들기 기본 IP 포트 사용 3260 네트워크 포털 10.11.102.164:3260을 만들었습니다. 새 노드 입력 /iscsi/iqn.2003-01.org.linux-iscsi.murray.x8664:sn.31fc1a672ba1/tpgt1/portals/10.11.102.164:3260 /iscsi/iqn.20…102.164:3260> cd ../ ../acls

마지막 단계

Linux 이니시에이터 (클라이언트 시스템)를 등록하여 Linux 소프트웨어 iSCSI 대상으로 저가 SAN 설정을하십시오. 이렇게하려면 시스템의 이니시에이터 이름을 찾아야합니다. Linux의 경우 보통 /etc/iscsi/initiatorname.iscsi에 있습니다. Windows의 경우 초 기자 이름은 구성 탭의 iSCSI 초 기자 속성 패널에 있습니다. /iscsi/iqn.20…a1/tpgt1/acls> iqn.1994-05.com.redhat : f5b312caf756 (이니시에이터 등록 -이 IQN은 초 기자의 IQN입니다.) – 대상에 액세스 할 각 초 기자에 대해이를 수행하십시오. iqn.1994-05.com.redhat의 노드 ACL 작성 : f5b312caf756 맵핑 된 LUN 0을 작성했습니다. 새 노드 입력 /iscsi/iqn.2003-01.org.linux-iscsi.murray.x8664:sn.31fc1a672ba1/tpgt1/acls/iqn.1994-05.com.redhat:f5b312caf756/iscsi/iqn.20….102.164 : 3260> cd / 지금, 설정을 저장하는 것을 잊지 마십시오. 이 단계가 없으면 구성이 지속되지 않습니다. /> saveconfig (설정을 저장하십시오!) /> exit 이제 초기화 장치를 대상에 연결해야합니다. 일반적으로 대상에 연결할 IP 주소를 제공해야합니다. 연결이 완료되면 클라이언트 시스템에 새 디스크가 표시됩니다. 사용하기 전에 디스크를 포맷해야합니다. 그리고 그게 다야! 새 SAN을 사용할 준비가되었습니다. 재미있어! Linux 소프트웨어 iSCSI 대상으로 저비용 SAN을 설정하는 데 문제가 있으면 Linux 클러스터링의 허가를 받아 복제했습니다.