SIOS DataKeeper를 사용하여 성능 테스트 복제를 수행하는 방법

프로덕션 데이터베이스에 대한 복제를 구성하는 것은 특히 사전 조사를 수행하지 않은 경우 매우 어려운 작업이 될 수 있습니다. 이 블로그에서는 환경을 적절하게 설정하는 데 있어 가장 까다로운 측면인 성능에 대한 여러 부분을 다룰 것입니다. 이러한 핵심 사항을 이해하면 앞서 나갈 수 있으며 프로덕션 Go-Live에 마지막 순간에 문제가 발생하지 않도록 할 수 있습니다.

고려해야 할 첫 번째이자 가장 기본적인 점은 구성에 맞는 올바른 미러 유형을 선택하는 것입니다. SIOS DataKeeper에는 생성 프로세스 중에 미러 유형에 대한 동기식 및 비동기식의 두 가지 옵션이 제공됩니다. 이러한 옵션 중 하나는 환경에 따라 고유한 장점과 단점이 있습니다.

미러 유형 선택

동기식 미러는 고속 연결이 가능한 LAN 환경에서 가장 뛰어난 성능을 발휘하며 기본 시스템에 대한 커밋 시 1:1 쓰기 일관성을 제공합니다. 그러나 네트워크 또는 대상 스토리지가 기본 시스템의 처리량을 따라잡을 수 없는 경우 동기 쓰기 일관성을 유지하기 위해 쓰기 속도가 감소하는 것을 볼 수 있습니다. 따라서 동기식 미러링은 WAN 또는 대기 시간이 긴 환경에는 권장되지 않습니다.

그러나 비동기식 미러는 WAN 환경에 적합합니다. 비동기식 미러는 노드 간 1:1 쓰기 일관성을 보장하는 동일한 기능을 모두 제공하지만 차이점은 쓰기가 대상 시스템에 커밋되기 전에 기본 시스템에 커밋된다는 것입니다. 이는 의도 로그라고도 알려진 비트맵의 활용으로 인해 가능합니다. 비트맵은 시스템에서 발생하는 모든 변경 사항을 블록 수준에서 추적하고 백로그라고 알려진 백로그를 통해 최대한 빠르게 대상에 데이터를 씁니다. 쓰기 대기열. 쓰기 대기열은 쓰기 수 또는 데이터의 총 MB에 따라 제한될 수 있으며, 제한에 도달하면 미러가 일시 중지되고 데이터가 동기화되므로 데이터가 동기화되지 않은 동안 장애 조치가 방지됩니다.

하드웨어 구성:

이제 환경에 가장 적합한 미러 유형을 결정했으므로 DataKeeper가 마법이 아니라는 점을 이해하는 것이 중요합니다. DataKeeper는 시스템이 허용하는 만큼만 빠르게 쓰고 복제할 수 있으므로 애플리케이션에 필요한 처리량을 달성할 수 있는 하드웨어를 보유하는 것이 중요합니다. 복제 목표를 달성하는 데 필요한 하드웨어를 갖추기 위한 몇 가지 조언과 팁은 다음과 같습니다.

- 기본 시스템과 대상 시스템에 동일한 스토리지 하드웨어가 있는지 확인하십시오. 예를 들어 대상 IOPS는 소스 IOPS와 동일해야 합니다. 그렇지 않으면 환경에서 가장 느린 구성 요소가 쓰기 속도의 병목 현상이 되는 것으로 드러납니다. 일치하는 하드웨어는 항상 더 나은 성능을 제공합니다.

- 비트맵의 중요성을 이해하면 성능을 크게 향상시키는 가장 쉽고 저렴한 방법은 전용 고속 스토리지에 비트맵을 저장하는 것입니다. 비트맵은 매우 작기 때문에 5GB 또는 10GB SSD를 프로비저닝하는 것으로 충분하며 성능 향상에 대한 큰 수익을 제공합니다.

- 데이터 복제로 인해 약간의 오버헤드가 발생한다는 점을 이해하고 독립형 하드웨어를 테스트하십시오. 예를 들어 환경에서 10,000 IOPS를 달성해야 하는 요구 사항이 있는 경우 하드웨어가 클러스터에 포함될 모든 노드에서 최소한 독립 실행형으로 일관된 10,000 IOPS를 달성할 수 있는지 확인하십시오. 동기식 미러링을 수행하려는 경우 동기식 일관성을 유지하기 위해 추가 오버헤드가 도입되므로 최소한의 요구 사항 이상인지 확인하십시오. 또한 복제 체계에 필요한 데이터를 전송할 수 있는지 확인하기 위해 네트워크 부하 테스트도 수행해야 합니다.

- 제대로 테스트하는 방법을 알아보세요. 생산 능력을 검증하기 위해 테스트 환경을 활용할 때 설정을 최대한 비슷하게 모방하는 것이 중요합니다. 단순히 복제를 테스트하기 위해 전체 운영 데이터베이스 복제본을 설정할 수는 없지만 올바른 데이터 생성 도구를 활용하면 현재 성능 기능을 더 잘 표시할 수 있다는 점을 이해합니다. Diskspd는 일부 기본 테스트에 사용할 수 있는 무료 도구이지만 SQL 세계에서는 HammerDB가 실제 성능에 대한 훨씬 더 나은 지표를 제공합니다.

디스크 속도:https://github.com/microsoft/diskspd

해머DB:https://www.hammerdb.com/

- 마지막으로 DataKeeper 조정이 있으며 DataKeeper 내에는 미러 유형 외에 구성 가능한 설정이 있습니다. 이를 수정하는 것은 일반적으로 좀 더 미묘하며 SIOS 지원 팀의 조언에 따라 가장 잘 수행됩니다. 그러나 다른 모든 권장 사항이 제대로 적용되었음을 확인한 경우 일부 DataKeeper 매개 변수를 조정하면 필요한 측정 항목을 충족하는 데 필요한 성능이 마지막으로 향상될 수 있습니다. 조정의 몇 가지 예로는 쓰기 대기열에 있을 수 있는 미해결 쓰기 수를 늘리거나 비트맵 파일이 디스크에 플러시되는 빈도를 수정하는 것입니다.

다음의 허가를 받아 복제됨시오스

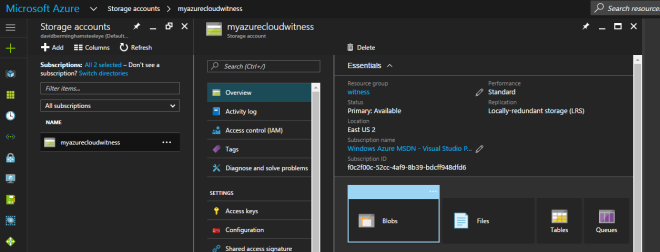

ailover) 클러스터를 Azure에서 빌드하려고 할 때 클라우드 감시 서버 저장소는 항상 구성되어야합니다. 로컬 중복 저장소 (Local Advisory Storage) (LRS) [/ caption]

ailover) 클러스터를 Azure에서 빌드하려고 할 때 클라우드 감시 서버 저장소는 항상 구성되어야합니다. 로컬 중복 저장소 (Local Advisory Storage) (LRS) [/ caption]